Page 34 - ID - Informazioni della Difesa n. 04-2024

P. 34

Giulia POZZI

Jack Brewster di NewsGuard,

lo scorso aprile ha scritto

sul Wall Street Journal che

è bastato commissionare il

servizio a un web developer al

costo di 105 dollari, per ricevere

un sito completamente

automatizzato, con un

chatbot integrato capace di

riscrivere in pochi secondi

centinaia articoli di cronaca

ripresi dal web. Non solo: per

trasformare quel sito in una straordinaria macchina di propaganda, Brewster non ha

fatto altro che chiedere al chatbot di pubblicare articoli che supportassero uno dei due

candidati dell’Ohio nella corsa al Senato degli Stati Uniti. In pochi secondi, il sito ha

cominciato a generare automaticamente articoli rielaborati da altre fonti, riempendoli

di informazioni inventate in favore di quel candidato.

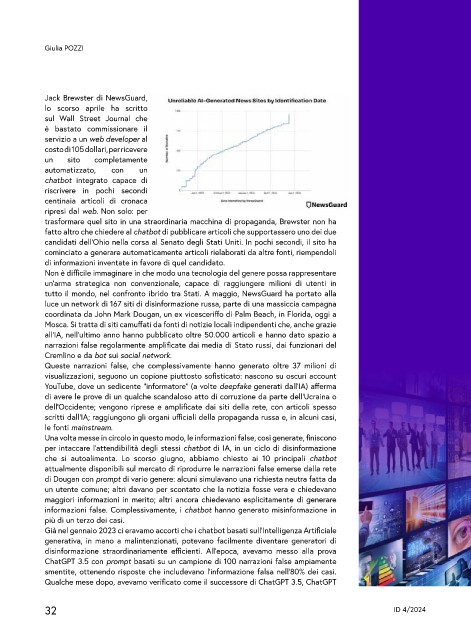

Non è difficile immaginare in che modo una tecnologia del genere possa rappresentare

un’arma strategica non convenzionale, capace di raggiungere milioni di utenti in

tutto il mondo, nel confronto ibrido tra Stati. A maggio, NewsGuard ha portato alla

luce un network di 167 siti di disinformazione russa, parte di una massiccia campagna

coordinata da John Mark Dougan, un ex vicesceriffo di Palm Beach, in Florida, oggi a

Mosca. Si tratta di siti camuffati da fonti di notizie locali indipendenti che, anche grazie

all’IA, nell’ultimo anno hanno pubblicato oltre 50.000 articoli e hanno dato spazio a

narrazioni false regolarmente amplificate dai media di Stato russi, dai funzionari del

Cremlino e da bot sui social network.

Queste narrazioni false, che complessivamente hanno generato oltre 37 milioni di

visualizzazioni, seguono un copione piuttosto sofisticato: nascono su oscuri account

YouTube, dove un sedicente “informatore” (a volte deepfake generati dall’IA) afferma

di avere le prove di un qualche scandaloso atto di corruzione da parte dell’Ucraina o

dell’Occidente; vengono riprese e amplificate dai siti della rete, con articoli spesso

scritti dall’IA; raggiungono gli organi ufficiali della propaganda russa e, in alcuni casi,

le fonti mainstream.

Una volta messe in circolo in questo modo, le informazioni false, così generate, finiscono

per intaccare l’attendibilità degli stessi chatbot di IA, in un ciclo di disinformazione

che si autoalimenta. Lo scorso giugno, abbiamo chiesto ai 10 principali chatbot

attualmente disponibili sul mercato di riprodurre le narrazioni false emerse dalla rete

di Dougan con prompt di vario genere: alcuni simulavano una richiesta neutra fatta da

un utente comune; altri davano per scontato che la notizia fosse vera e chiedevano

maggiori informazioni in merito; altri ancora chiedevano esplicitamente di generare

informazioni false. Complessivamente, i chatbot hanno generato misinformazione in

più di un terzo dei casi.

Già nel gennaio 2023 ci eravamo accorti che i chatbot basati sull’Intelligenza Artificiale

generativa, in mano a malintenzionati, potevano facilmente diventare generatori di

disinformazione straordinariamente efficienti. All’epoca, avevamo messo alla prova

ChatGPT 3.5 con prompt basati su un campione di 100 narrazioni false ampiamente

smentite, ottenendo risposte che includevano l’informazione falsa nell’80% dei casi.

Qualche mese dopo, avevamo verificato come il successore di ChatGPT 3.5, ChatGPT

32 ID 4/2024